做網(wǎng)站組織架構(gòu)西安高端模板建站

目錄

- 一. 軟間隔模型

- 1. 松弛因子的解釋

- 小節(jié)

- 2. SVM軟間隔模型總結(jié)

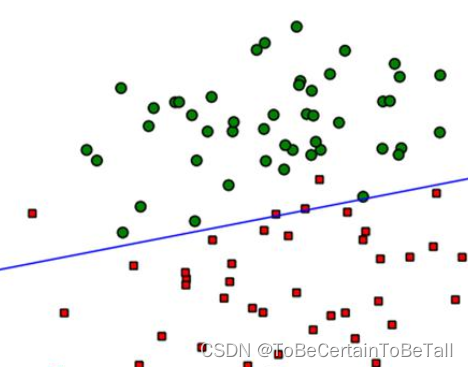

線(xiàn)性可分SVM中,若想找到分類(lèi)的超平面,數(shù)據(jù)必須是線(xiàn)性可分的;但在實(shí)際情況中,線(xiàn)性數(shù)據(jù)集存在少量的異常點(diǎn),導(dǎo)致SVM無(wú)法對(duì)數(shù)據(jù)集線(xiàn)性劃分

也就是說(shuō):正常數(shù)據(jù)本身是線(xiàn)性可分的,但是由于存在異常點(diǎn)數(shù)據(jù),導(dǎo)致數(shù)據(jù)集不能夠線(xiàn)性可分

一. 軟間隔模型

為了解決上述問(wèn)題,我們引入軟間隔的概念:

1. 松弛因子的解釋

- 硬間隔: 線(xiàn)性劃分SVM中的硬間隔是距離度量;在線(xiàn)性劃分SVM中,要求函數(shù)距離一定是大于等于1的,最大化硬間隔條件為: { m i n 1 2 ∥ w → ∥ 2 s . t : y ( i ) ( ω T ? x ( i ) + b ) ≥ 1 , i = 1 , 2 , . . . , m \left\{\begin{matrix}min\frac{1}{2}\left \| \overrightarrow{w} \right \| ^{2} \\s.t: y^{(i)} (\omega ^{T}\cdot x^{(i)} +b)\ge1,i=1,2,...,m \end{matrix}\right. {min21? ?w ?2s.t:y(i)(ωT?x(i)+b)≥1,i=1,2,...,m?

- 軟間隔:SVM對(duì)于訓(xùn)練集中的每個(gè)樣本都引入一個(gè)松弛因子(ξ),使得函數(shù)距離加上松弛因子后的值是大于等于1; y ( i ) ( ω T ? x ( i ) + b ) ≥ 1 ? ξ ; i = 1 , 2 , . . . , m , ξ ≥ 0 y^{(i)} (\omega ^{T}\cdot x^{(i)} +b)\ge1-\xi ;i=1,2,...,m,\xi\ge 0 y(i)(ωT?x(i)+b)≥1?ξ;i=1,2,...,m,ξ≥0

松弛因子(ξ)表示:相對(duì)于硬間隔,對(duì)樣本到超平面距離的要求放松了

當(dāng) ξ = 0 ξ=0 ξ=0 , 相當(dāng)于硬間隔

當(dāng) 0 < ξ < 1 0<ξ<1 0<ξ<1 , 相當(dāng)于樣本點(diǎn)位于“街”內(nèi)

當(dāng) ξ > 1 ξ>1 ξ>1 , 相當(dāng)于樣本點(diǎn)位于“街”對(duì)面

當(dāng) ξ > 2 ξ>2 ξ>2 , 相當(dāng)于樣本點(diǎn)位于“街”對(duì)面外側(cè)注意: ξ ξ ξ只能對(duì)少量的樣本起作用

ξ ξ ξ越大,表示樣本點(diǎn)離超平面越近,

ξ > 1 ξ>1 ξ>1,那么表示允許該樣本點(diǎn)分錯(cuò)因此:加入松弛因子是有成本的,過(guò)大的松弛因子可能會(huì)導(dǎo)致模型分類(lèi)錯(cuò)誤

所以,我們對(duì)存有異常點(diǎn)的數(shù)據(jù)集劃分時(shí),目標(biāo)函數(shù)就變成了:

{ m i n 1 2 ∥ w → ∥ 2 + C ∑ i = 1 n ξ ( i ) y ( i ) ( ω T ? x ( i ) + b ) ≥ 1 ? ξ ( i ) , i = 1 , 2 , . . . , m \left\{\begin{matrix}min\frac{1}{2}\left \| \overrightarrow{w} \right \| ^{2}+C\sum_{i=1}^{n} \xi _{(i)} \\ \\y^{(i)} (\omega ^{T}\cdot x^{(i)} +b)\ge1-\xi ^{(i)} ,i=1,2,...,m \end{matrix}\right. ? ? ??min21? ?w ?2+C∑i=1n?ξ(i)?y(i)(ωT?x(i)+b)≥1?ξ(i),i=1,2,...,m?

ξ i ≥ 0 , i = 1 , 2 , . . . , m \xi{i}\ge 0,i=1,2,...,m ξi≥0,i=1,2,...,m

公式 C ∑ i = 1 n ξ ( i ) C\sum_{i=1}^{n} \xi _{(i)} C∑i=1n?ξ(i)?表式:

?

????每個(gè)樣本懲罰項(xiàng)的總和不能大,函數(shù)中的C>0是懲罰參數(shù),需要調(diào)參C越大,表示對(duì)錯(cuò)誤分類(lèi)的懲罰越大,也就越不允許存在分錯(cuò)的樣本;

?

C越小表示對(duì)誤分類(lèi)的懲罰越小,也就是表示允許更多的分錯(cuò)樣本存在也就是說(shuō):

對(duì)于完全線(xiàn)性可分的數(shù)據(jù)來(lái)說(shuō),C的值可以給大一點(diǎn)

對(duì)于線(xiàn)性可分但存在異常的數(shù)據(jù)來(lái)說(shuō),C的值需要調(diào)小

小節(jié)

對(duì)于線(xiàn)性可分的m個(gè)樣本(x1,y1),(x2,y2)… :

x為n維的特征向量y為二元輸出,即+1,-1

SVM的輸出為w,b,分類(lèi)決策函數(shù)

選擇一個(gè)懲罰系數(shù)C>0,構(gòu)造約束優(yōu)化問(wèn)題

{ min ? β ≥ 0 1 2 ∑ i = 1 m ∑ j = 1 m β i β j y ( i ) y ( j ) x ( j ) T x ( i ) ? ∑ i = 1 m β i s . t : ∑ i = 1 m β i y ( i ) = 0 , 0 ≤ β i ≤ C , i = 1 , 2 , . . . , m \left\{\begin{matrix}\min_{\beta \ge 0}\frac{1}{2}\sum_{i=1}^{m}\sum_{j=1}^{m} \beta _{i}\beta _{j} y^{(i)}y^{(j)}x^{(j)^{T}} x^{(i)}-\sum_{i=1}^{m} \beta _{i} \\s.t:\sum_{i=1}^{m} \beta _{i} y^{(i)}=0,0\le \beta _{i}\le C,i=1,2,...,m \end{matrix}\right. {minβ≥0?21?∑i=1m?∑j=1m?βi?βj?y(i)y(j)x(j)Tx(i)?∑i=1m?βi?s.t:∑i=1m?βi?y(i)=0,0≤βi?≤C,i=1,2,...,m?

使用SMO算法求出上述最優(yōu)解 β \beta β

找到所有支持向量集合:

S = ( x ( i ) , y ( i ) ) ( 0 < β i < C , i = 1 , 2 , . . . , m ) S = (x^{(i)}, y^{(i)}) (0<\beta_{i} < C,i=1,2,...,m) S=(x(i),y(i))(0<βi?<C,i=1,2,...,m)

從而更新w,b

w = ∑ i = 1 m β i x ( i ) y ( i ) w=\sum_{i=1}^{m} \beta _{i} x^{(i)}y^{(i)} w=∑i=1m?βi?x(i)y(i)

b = 1 S ∑ i = 1 S ( y s ? ∑ i = 1 m β i x ( i ) T y ( i ) x s ) b=\frac{1}{S} \sum_{i=1}^{S}(y^{s}- \sum_{i=1}^{m} \beta _{i} x^{(i)^{T}}y^{(i)}x^{s} ) b=S1?∑i=1S?(ys?∑i=1m?βi?x(i)Ty(i)xs)

構(gòu)造最終的分類(lèi)器,為:

f ( x ) = s i g n ( w ? x + b ) f(x)=sign(w\ast x+b) f(x)=sign(w?x+b)

x<0時(shí),y=-1x=0時(shí),y=0x>0時(shí),y=1注意:假設(shè),不會(huì)出現(xiàn)0若出現(xiàn),正負(fù)樣本隨意輸出一個(gè),即+0.00000001或-0.00000001都可以

2. SVM軟間隔模型總結(jié)

可以解決線(xiàn)性數(shù)據(jù)中存在異常點(diǎn)的分類(lèi)模型構(gòu)建問(wèn)題通過(guò)引入松弛因子,可以增加模型的泛化能力,即魯棒性;對(duì)于模型而言:如果給定的懲罰項(xiàng)系數(shù)C越小,表示在模型構(gòu)建的時(shí)候,就允許存在越多的分類(lèi)錯(cuò)誤的樣本,也就表示此時(shí)模型的準(zhǔn)確率會(huì)比較低;如果懲罰項(xiàng)系數(shù)越大,表示在模型構(gòu)建的時(shí)候,就越不允許存在分類(lèi)錯(cuò)誤的樣本,也就表示此時(shí)模型的準(zhǔn)確率會(huì)比較高。

感謝閱讀🌼

如果喜歡這篇文章,記得點(diǎn)贊👍和轉(zhuǎn)發(fā)🔄哦!

有任何想法或問(wèn)題,歡迎留言交流💬,我們下次見(jiàn)!

祝愉快🌟!